Agence IA Casablanca

LLM, RAG, bases vectorielles et assistants intelligents (OpenAI, Gemini, Llama)

L'intelligence artificielle transforme la manière d'opérer. Nous déployons des solutions IA adaptées à vos enjeux métiers.

Notre approche IA se concentre sur les LLM (OpenAI, Gemini, Llama), l'architecture RAG (Retrieval-Augmented Generation) et les assistants intelligents reliés à vos données pour automatiser, enrichir et optimiser vos processus.

Notre méthodologie IA

RAG & Bases Vectorielles

Architectures RAG ancrant les réponses des LLM dans vos contenus. Ingestion, chunking, embeddings, indexation et retrieval pertinents.

Embeddings (OpenAI, open‑source), stockage vectoriel (pgvector, Qdrant/Weaviate), citations, filtres, et garde‑fous (safety, confidentialité).

Intégration APIs (OpenAI, Gemini)

Orchestration LLM (function calling, outils, sorties structurées), prompts robustes, coûts/latences maîtrisés. Pas d'entraînement ML bespoke.

Gouvernance, cache, monitoring, retries/timeouts/fallbacks. Conformité et confidentialité garanties.

Chatbots & Assistants Intelligents

Conception d'assistants LLM reliés à vos données via RAG. Support, recherche interne, qualification de prospects, automatisation.

Multilingues, contextuels, intégrés (CRM, helpdesk). Journalisation minimale et « ephemeral keys » quand possible.

Déploiement Local (Llama) & Observabilité

Modèles locaux (Llama) pour cas sensibles (Ollama/llama.cpp, GPU/CPU). Choix, quantization, optimisation.

Observabilité (coûts, tokens, latences, qualité), guardrails et évaluation continue. Orchestration des workflows IA.

Expertise IA par Secteur

IA Banking & Finance

Chatbots bancaires, assistants self-care, qualification clients, analyse documents (KYC) et recommandations personnalisées.

En savoir plus →IA E-commerce & Support Client

Recommandations produits, recherche sémantique, chatbots e-commerce et automatisation support client.

En savoir plus →IA Santé & Knowledge Management

Assistants médicaux, recherche documentaire, bases de connaissances vectorielles et analyse de données santé.

En savoir plus →Nos réalisations IA

Hub Digital Panafricain

Hub Digital Attijariwafa bank

Assistants LLM reliés au contenu via RAG, recherche sémantique et parcours par besoins.

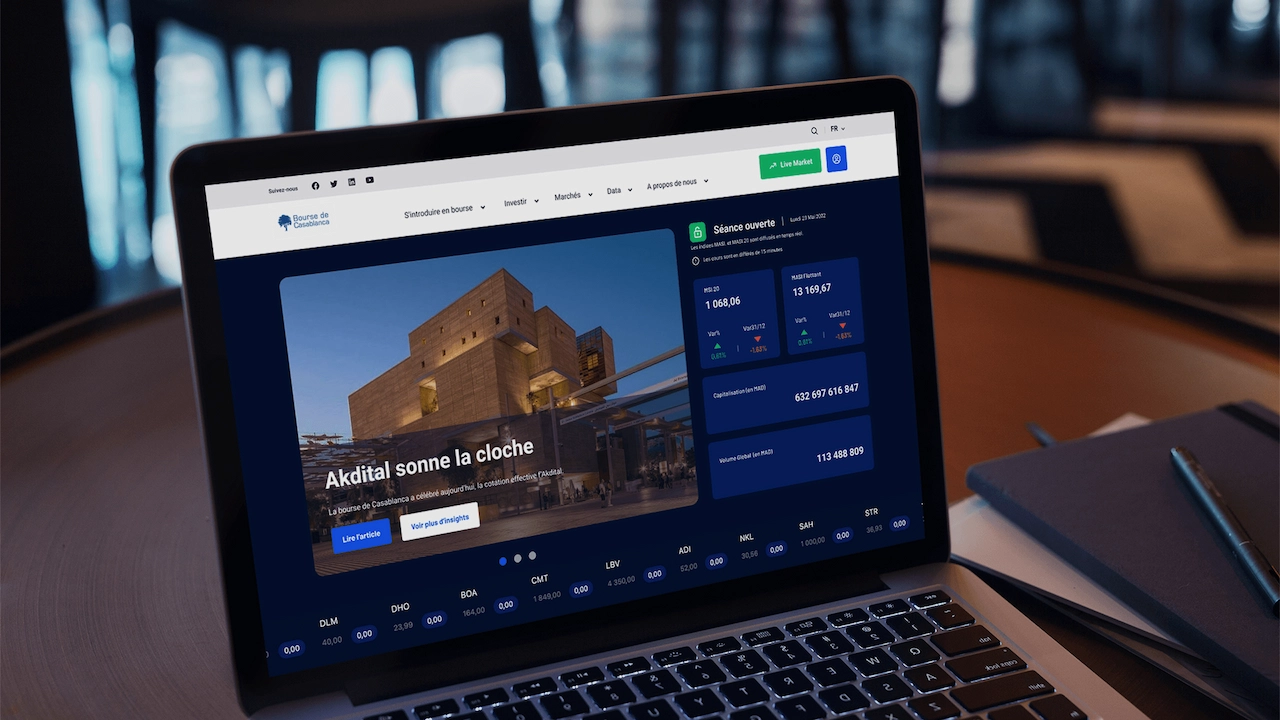

Plateforme Financière

Bourse de Casablanca

RAG orienté données financières et FAQ, vectorisation des contenus et réponses sourcées.

Écosystème Digital Santé

La Fondation Mohammed VI des Sciences et de la Santé

Base vectorielle et assistants pour la recherche d'information multi‑portails (UM6SS, établissements).

Services IA Maroc

Développement Chatbots & Assistants

Chatbots intelligents, assistants virtuels, intégration LLM (OpenAI, Gemini) et connexion à vos données.

RAG & Recherche Sémantique

Architecture RAG, bases vectorielles (pgvector, Qdrant), embeddings et retrieval pour réponses précises.

Intégration LLM (OpenAI, Gemini)

Intégration APIs LLM, orchestration, function calling, prompts robustes et gestion coûts/latences.

Fine-tuning & Modèles Locaux

Déploiement local (Llama, Ollama), fine-tuning modèles, quantization et optimisation GPU/CPU.

Audit & Stratégie IA

Audit opportunités IA, roadmap, POC, observabilité (tokens, coûts, qualité) et gouvernance.

Pourquoi choisir VOID pour votre projet IA ?

Expertise sectorielle : +30 projets bancaires, fintech, e-commerce et santé au Maroc et en Afrique. Maîtrise des contraintes réglementaires (CNDP, confidentialité).

Stack IA moderne : OpenAI GPT-4/GPT-4o, Google Gemini, Llama (local), bases vectorielles (pgvector, Qdrant) et frameworks RAG (LangChain, LlamaIndex).

Pas d'entraînement ML bespoke : nous capitalisons sur les LLM pré-entraînés et le RAG pour ancrer les réponses dans vos données, sans ML custom coûteux.

Observabilité & gouvernance : monitoring tokens, coûts, latences, qualité des réponses. Guardrails, filtres de sécurité et conformité CNDP.

Déploiement flexible : cloud (OpenAI API, Gemini API) ou local (Llama, Ollama) selon vos contraintes de confidentialité et souveraineté.

Explorez aussi

Découvrez nos autres expertises complémentaires.